Protecting Beyond DNS Flood & DDoS

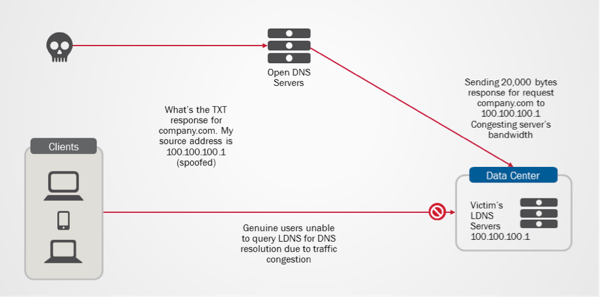

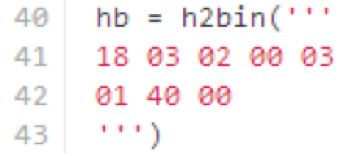

The recent slate of cyber-attacks involving DNS and NTP systems has again prompted questions about the comprehensiveness of DNS infrastructure’s security protection. Besides mitigating volumetric attacks such as DNS flood & DDoS, many organizations have realized the need for a more comprehensive DNS security protection, which helps in preventing DNS-related security frauds and non-volumetric based attacks such as amplification and cache poisoning attacks. On DNS Amplification & DNS Reflection Attacks You might concur that increasing DNS performance with adequate DNS rate limiting mechanism is probably one of the best approaches to tackle the problem of overwhelming DNS traffic and DNS DoS attacks. However, this does not address the issue of DNS Amplification and DNS reflection attacks, which has been made popular through the Spamhaus-Cyberbunker attack incident. In this incident, CyberBunker took the advantage of open DNS resolvers to launch DNS amplification attacks, causing Spamhaus to be unreachable at times. DNS amplification and reflection attacks are typically sent to DNS servers as legitimate DNS request, in hope to receive large data size responses. The huge data size responses will eventually use up all the available bandwidth causing congestion to genuine DNS queries and responses. As such, DNS query rate limiting mechanism and higher QPS performance will not be able to counter the attack since the attacks typically come in small numbers of DNS requests. One of the ways to limit such attacks is to filter the request based on query type. Typically, DNS amplification and reflection attacks will request for ‘TXT’ or ‘ANY’ Query Type which tends to return responses with significant data size. By applying bandwidth rate limit to these query type request and large-data-size query responses, we will be able to prevent bandwidth congestion caused by these attacks. Worried about the complexity of the bandwidth rate limiting solution? Well, it only takes less than 10 lines of iRules (shown as below) on F5 DNS platform to get this enforced and implemented. when DNS_REQUEST { if { ([DNS::question type] eq "TXT") } { rateclass dns_rate_shape } } when DNS_RESPONSE { if { ([DNS::len] value > 512) } { rateclass dns_rate_shape } } Diagram 1: DNS Reflection attacks blocking genuine users from accessing LDNS server. Cache Poisoning Attacks DNSSEC is poised as the eventual and ultimate solution to counter DNS cache poisoning attacks. Though the adoption rate of DNSSEC is encouraging, it takes all parties to deploy DNSSEC signing and validation to fully protect against cache poisoning. While waiting for DNSSEC adoption rate to mature, is there any interim solution to reduce or prevent cache poisoning attacks? Based on DNS RFC standards, name servers are required to treat domain names request with case-insensitivity. In other words, the names www.foo.com and WWW.FOO.COM should resolve to the same IP address. However, most name servers will preserve the original case when echoing back the domain name in the response. Hence, by randomly varying the case of characters in domain names queried, we will be able to add entropy to requests. With this verification mechanism, the name server response must match the exact upper and lower case of every character in the name string; for instance, wWw.f5.CoM or WwW.f5.COm, which significantly reduces the success rate of cache poisoning attacks. With F5’s DNS solution, this mechanism can be enabled with just a check box on the management pane. The packet capture of the query case randomization process by F5 DNS is shown as below. As depicted in the diagram, for queries to www.google.com, F5 Cache DNS will randomize the character case of the query prior sending the query to Google’s authoritative DNS server. This greatly reduces the chances of unsolicited queries matching the domain name and DNS request transaction ID, which causes the poisoning of cached DNS records. Diagram 2: Character case randomizer in F5 DNS solution dramatically reduces the possibilities of DNS cache poisoning attacks DNS is among the hoariest of internet services that is still widely used today. Its usage continues to grow due to its simplicity and proliferation of smart devices. Hence, it is truly important that proper solution design and architecture approach are being put in place to protect the infrastructure. After all, the protection investment might be only a fraction of what you are paying for during an attack.650Views0likes5CommentsHTTPS的"S"不代表SSL

This is a localised version of the original articlehere. 當瀏覽器出現一個掛鎖圖像時,我們很自然的會假設該網站正使用SSL以確保我們的通訊安全。它同時也告知消費者該網站是安全的。根據CA Security Council的2015消費者信任調查,只有3%消費者會將他們的信用卡資訊提供給沒有掛鎖圖像的網站。 此種安全印象的影響性並不局限於消費者。F5最新的應用交付現狀調查報告顯示,已經或有計畫建置"SSL Everywhere"的受訪者表示,對於他們企業承受應用層攻擊的能力比較有信心,在1到5的信心評分中獲得3或更高的評價。 事實是,大多數人無法告訴你SSL代表什麼意義,更別說是描述它的運作方式。他們只知道那是一種確保應用或網站交易,包含潛在的機密資訊的安全機制。 那有一部分是科技專有名詞描述的錯。我們用SSL來描述協定(RFC 6101),以及作為描述一個安全連接的通稱。SSL是安全性的通稱,就好像Google是搜索引擎或者舒潔是衛生紙的代名詞一樣。 實際上,HTTPS並不是真的需要SSL。HTTPS的"S"代表安全(secure),而且它只簡單的要求提供確保二個端點,例如一個瀏覽器和一個Web網站之間安全連接的方法。而且,越來越明顯的是,其所代表的意義事實上是指在TLS協定(而非SSL)之上的HTTP。 這是一個很重要的區別,因為儘管它們有著相同的根源,但TLS並不是SSL,SSL也不是TLS。它們是不同的協定,各有它們本身獨特的挑戰、問題和衝擊效應。二者都是以相同的方式確保安全連接 - 它們使用安全憑證以進行認證,以及使用公鑰/私鑰加密 - 然而雙方仍存在著建置上的差異性。 我們為何要關注這件事?你應該在意,因為最新的Web應用協定HTTP/2和SPDY並不支援SSL。它們支援的是TLS。它們本身並沒有這樣的要求,不過支援這二項協定的瀏覽器只能在TLS(而非SSL )之上提供該項支援。 必須承認的是,今天使用HTTP/2或SPDY的網站並不多,但數量正在成長。在W3CTech (July 2015)報導中指出,新的HTTP/2標準已於2015年5月發行最終版,現在獲得所有網站的0.4% (高於7月初的0.24%)以及頂尖1000網站的7.5% 採用。也就是說頂尖的1000網站中,現在有7.5% 藉由HTTP/2提供內容服務。 我們談論的並不是只局限於瀏覽器和伺服器。我們同時也必須思考在整合上所代表的意義,當使用頂尖1000網站的一些API時,或許會被迫非僅採用HTTP/2或SPDY,而且也包括TLS 。Google所有公共服務的加密都是使用TLS。如果你要整合Google的一些功能,就應注意他們使用的是TLS而非SSL。因為這有著實質上的差異。 另外還必須注意的是它涉及到商業上一些盤根錯節的問題。在支付卡產業(PCI)標準規範下,SSL在2016年6月30日之後不得繼續使用。那個時間點之後,將明確要求採用TLS。這意謂著必須做一些改變以維持遵循PCI。當然,你會做相應的配合,因為如果不遵循標準的話將面對很多複雜的挑戰。例如,信用卡發行者會要求較高的商家帳戶費用和罰鍰,或者完全取消你的支付與交易處理資格。如果發生權利侵害事件,你的公司將因為未能在安全性上做到正當注意調查(due diligence)而面對較高的法律訴訟與罰責風險。 當然,如果說期望你此刻就要從SSL轉移到TLS,也是不實際的。畢竟,雖然TLS是以SSL v3為基礎,但它並非100% 向下相容,而且需要做一些組態變更才能取消SSL以迫使使用TLS。組態變更通常需要進行一次重新啟動。對一個大規模環境而言,這個程序必然會造成服務中斷而且耗費時間。 不過,現在正是開始認真考慮的時刻,你必須決定還要支援SSL多久以及何時要轉移到純正的TLS。291Views0likes0CommentsF5 Agility Singapore 2015

Every year, our Agility conferences travel the world to showcase how F5 and partners empower organizations to harness the latest technologies to overcome business challenges. The flagship series also serve as a forum for industry experts to network and discuss disruptive IT trends. This year, Agility 2015 in Singapore focused on how businesses can innovate new paths to success, expand through barriers to growth, and deliver the applications that are critical in today’s mobile driven world. The power of cloud, data centers, hybrid systems, and as-a-Service were key topics that dominated conversations, with F5 executives and partners sharing perspectives on IT approaches to achieve application availability, security, programmability, and software defined networking (SDN) for 2015 and beyond Fuelling the conversation as well was the recent release of the New Language of Cloud Computing whitepaper from F5 and Frost & Sullivan, based on findings from a survey of decision-makers in Asia Pacific. Key insights included the fact that 58.6% of organization decision-makers identify cloud computing as their #1 priority in the next 12 months, and 91% of enterprises either already use cloud services or are currently in the planning or implementing stage. Held in Singapore at the Ritz-Carlton on 5 May, Agility Singapore 2015 saw a great turnout of attendees which consisted of C-suite decision makers, executives from senior IT management and industry experts.181Views0likes0CommentsF5 predicts: IT departments to become brokers

IT brokers In this rapidly evolving age of technology, business demands are constantly changing. New technology innovations are introduced into the market at a dizzying rate. IT departments have the core role of providing technology solutions for business problems within organizations. However, instead of delivering these solutions themselves, IT departments of tomorrow will deliver solutions by managing relationships with multiple third-party IT innovators. This is to ensure the latest technology; a wider depth of technical expertise, as well as higher efficiency and allocation of manpower resources internally. To understand this shift in roles and relationships, we first examine how third-party IT innovations have helped businesses meet the changing demands of the current age with cloud and security solutions, and the various benefits of maintaining relationships with third-party IT innovators. Third-party innovations to meet changing business demands Robust third-party technological solutions are valued above all, for these bring a drastic increase in efficiency, productivity, agility and more importantly, competitive advantage. Cloud Solutions A 2012 study by the IBM Institute for Business Value and Economist Intelligence Unit, which surveyed 572 business and technology executives across the world, found that 90% expect to have implemented cloud in their organizations in the next three years. This brings the expected growth now to 41% from 13% at the time of the study. In this digital age, consumers have drastically changed their browsing and purchasing behavior. According to research by Gartner, it is predicted that more than 7 billion people and businesses, and at least 30 billion devices will be online by 2020 — which means most of the world will communicate and transact in the online sphere. To cope with this change, businesses have to adapt their strategies accordingly — i.e. find more efficient ways to conduct processes, share and exchange information, reach consumers and at the same time, ensure these transactions are accomplished in a secure environment. An example of an organization that has reworked its business model with a cloud computing solution is Etsy, a widely used online marketplace for handmade goods. Etsy “is able to cost-effectively analyze data from the approximately one billion monthly views of its Web site and use the information to create product recommendations.” (Forbes, 2012) According to research by Gartner, in 2015, “at least 20% of all cloud services will be consumed via internal or external cloud service brokerages, rather than directly, up from less than 5% today”. While the debate has mostly revolved around internal (private) and external (public) cloud models, it seems like the hybrid model may be a more viable solution amongst businesses concerned primarily with security. For example, Action for Children works with about 50,000 children and young adults in more than 600 projects worldwide. The organization needed to keep sensitive data in-house, and at the same time, manage web traffic and conduct data analysis for a deeper understanding of their customers for fundraising activities. They achieved this through a hybrid cloud solution. Security Solutions “Through 2015, mitigating data breaches will cost 10 times more than installing data protection mechanisms on mobile devices.” Gartner, November 2010 Security has become critical aspect of the digital age and will require the know-how of third-party service providers. The adoption of solutions from multiple parties, coupled with vast amounts of information shared and transacted online between and among service providers and organizations require security solutions to shield sensitive data. Organization networks today are subject to targeted attacks and intrusions. Denial-of-Service (DOS) attacks for example, can knock out critical applications, which in turn affects both businesses and its customers. Hackers are also constantly evolving their attack vectors. This online battlefield can prove bewildering to the IT department. Third-party service providers offer both expertise and robust infrastructures to ensure the protection and availability of organization’s networks. The advantages of brokerage There are multiple plus-points to IT departments forging and maintaining relationships with third-party service providers. These relationships can be put in place through various contractual agreements, including Service Level Agreements (SLAs). First, service providers are equipped with all the new technologies available and most applicable for use in the organization, as well as the knowledge of best practices within the industry. IT departments can therefore avail itself to the best technology fit for its organization. IT departments can also better manage and deploy their internal manpower. IT departments have been accused of being ‘disconnected’ from the business. In this way, IT staff can be devoted to understanding the business and propose the best technology from its service providers. This model will also make it easier for the IT department to demonstrate value, as they will be able to reduce and manage cost and measure productivity. Furthermore, this can be done at a faster pace. Days when enterprise application implementation took 1 to 2 years will remain in the pass. IT departments can move from a cost center to being a cost controller. The role of IT departments in businesses is continuing to evolve more in light of changing consumer demands. The full realisation of this has yet to be seen, but we look forward to what’s yet to come.227Views0likes0CommentsSSL Heartbleed 취약성: 영향과 대응책 (part 2)

(1부에서 계속) 그렇다면 클라우드는? 깊은 지식을 가지고 있는 독자라면 클라우드 컴퓨팅은 자신의 독자적인 Heartbleed 위협 프로파일을 가지고 있음을 눈치챘을 것이다. 그것은 사실이며, 특정 클라우드의 구축 상황에 따라 위협의 강도가 다르기 때문이다. 전형적인 LAMP 클라우드 사이트: 전형적인 클라우드 사이트는 Apache, MySQL 및 PhP가 구동되는 리눅스 배포 (보통 줄여서 LAMP라고 불린다) 인스턴스들을 포함하고 있다. 클라우드가 도입된 것이 상대적으로 최근의 현상이며 Heartbleed 취약성이 2년 전에 알려진 것과 시기가 겹치는 것을 생각할 때, 이런 클라우드 LAMP 사이트들이 가장 위험하다. F5 ADC 하드웨어를 가진 클라우드: 많은 고객들이 자신들의 클라우드 인스턴스들 앞 단에 F5의 하드웨어 플랫폼을 두고 있다. F5 ADC가 TCP 연결들을 병합하고, 공통 객체들을 캐시하고, 또한 당연한 일이지만 성능이 많이 요구되는 하드웨어 암호화 연산에 따른 부하를 덜어주기 때문에 효율성이 눈에 띄게 좋아진다. 이런 고객들은 F5가 SSL을 종료하므로 이미 보호되고 있다. 만약 당신이 이런 경우라면, 단순히 가상 서버들이 HTTPS의 암호화를 해제하지 않은 채내보내지 않도록 하기만 하면 된다. (아래 참조) F5 가상 ADC: 완전히 가상화된 클라우드에서는 F5 모듈도 가상 인스턴스이다. 근본적인 암호화 하드웨어 오프로드가 생기지 않으면, F5 모듈이 HTTPS 서버들을 위해 SSL을 종료하도록 하는 것이 덜 매력적일 것이다. 그러므로 하드웨어로 구축된 앞의 경우에 비해 Heartbleed 위험성이 높아진다. 그러나 이 경우도 F5 플랫폼이 방어를 제공할 수 있는데, 그 이유는 가상 ADC에 내재하는 SSL 스택의 소프트웨어가 Heartbleed에 취약하지 않으며 따라서 충분한 방어를 제공하기 때문이다. 다음 단계 기존 F5 고객들은 단순히 단일 솔루션을 읽고 자신이 보유한 F5 디바이스의 안전성을 재확인한 후, 자신이 현재 안전할 뿐 아니라 자신의 애플리케이션들이 지난 2년 동안 Heartbleed에 성공적으로 맞서왔음을 알고 두 다리 뻗고 자면 된다. 만약 도움이 필요할 경우, 아래의 F5에 연락하기를 클릭해서 F5 코리아에 연락을 취하면 된다. 만약 F5가 생소한 고객이라면, F5 코리아에 연락을 취해 현재와 미래의 위협으로부터 자신의 비즈니스를 보호할 것을 권장한다. F5에 연락하기 결론 미국의 컴퓨터 공학자인 제럴드 와인버그 (Gerald Weinberg)는 “만약 프로그래머들이 프로그램을 작성하는 것처럼 건축가들이 건물을 짓는다면, 이런 건축물을 찾는 첫 번째 딱따구리가 문명 전체를 파괴해버릴 것이다.”라고 말한 일이 있다. Heartbleed야말로 바로 그런 딱따구리라고 말할 수 있다. 하지만 좋은 소식은 F5 BIG-IP 디바이스들과 가상 인스턴스들이 벌써 인터넷에 널리 퍼져 있으며 그들이 담당하고 있는 HTTPS 애플리케이션들을 보호하고 있다는 것이다. 운영자들은 그렇게 방어되고 있음을 검증할 수 있으며, 보안 팀과 협력해 자신에 맞는 속도로 시스템을 업그레이드할 수 있다. 그리고 현재 보호받지 못하고 있는 사람들은 단순히 F5에 전화를 걸거나, F5의 시험용 버전을 이용해 보호를 받을 수 있다. * 현재 LTM에서 SSL 터미네이션을 하고 있는 경우, 11.5.0이나 11.5.1에서 디폴트 암호화를 COMPAT로 바꿔서 보안 F5 SSL 스택을 벗어나게 하지만 않았다면, 보호되고 있다. F5의 고객 중 이런 경우는 그 수가 매우 작은 것으로 판명되었다. 만약 11.5.0 또는 11.5.1을 사용 중이고 관리 인터페이스가 인터넷에 노출되었다면, 취약하다. BIG-IP 관리 인터페이스에는 OpenSSL 1.0.2이 사용된다. F5는 이런 구성을 권장하지 않는다. Heartbleed에 대해 질문이 있으신가요? F5 커뮤니티에 물어보세요. *F5의 끊임 없이 진화하는 커뮤니티에서 배우세요. 191개 국가의 13만 명이 넘는 뛰어난 사람들로 구성되어 있습니다.184Views0likes0CommentsSSL Heartbleed 취약성: 영향과 대응책

Heartbleed는 아마도 역사상 최악의 보안 취약성이라 할 수 있을 것이다. 더 안 좋은 점은 Heartbleed를 가능하게 만들고, 인기도 있는 OpenSSL 라이브러리가 지난 2년 이상 폭넓게 쓰였다는 점인데, 이 말은 이 취약점이 인터넷에 널리 퍼져있다는 의미이다. 게다가 더 문제가 되는 점은 Heartbleed의 존재를 알고 있는 공격자들은 누구나 간단하고 추적이 불가능한 메시지를 이용해 취약한 서버의 메모리 값을 빼낼 수 있다는 것이다. 그림 1: Heartbleed 탐침 적절하게 보호되지 못한 자원들은 SSL 프라이비트 키, 사용자 패스워드, 그리고 기타 매우 민감한 정보들을 포함하고 있을 수 있다. 간단하게 말해 Heartbleed는 최악의 시나리오에 무척 가깝다. 희소식 희소식이 있는데, 지난 2년 내에 당신의 HTTPS 애플리케이션을 F5 BIG-IP 애플리케이션 딜리버리 컨트롤러 (ADC)가 제공하고 있었다면 그 애플리케이션은 Heartbleed에 취약하지 않다는 것이다. F5 고객들과 다른 조직들을 대신해 해야 할 일이 아직 조금 더 있기는 하지만, F5는 즉각적인 대응책과 그 다음 단계들을 포함해 Heartbleed에 취약하지 않은 세상으로의 움직임을 이미 시작했다. 인터넷에 미치는 영향에 대한 분석 Heartbleed 취약성이 발표된 후에 Netcraft는 이 위협 표면의 핵심 파라미터들에 기반한 분석을 실시했다. Netcraft의 분석 결과에 따르면, 현재 SSL사이트 전체 중 약 15%가 Heartbleed에 노출되어 있는데, 이 말은 50만 개 이상의 프라이비트 키가 노출되어 있다는 뜻이다. 물론 각 SSL 키는 그들의 값에 따라 보안 수준이 다르다. 예를 들어 온라인 뱅킹 사이트의 프라이비트 키 보안은 뉴스 포털의 프라이비트 키보다는 훨씬 중요하다. 최상위 인증서 (root certificate) 승인 키들은 세상에서 가장 소중하다. 그렇다면 누가 취약한가? Heartbleed 위험성을 최초로 발표할 때 어떤 사이트들이 안전하고 어떤 사이트들은 안전하지 않은지도 함께 발표되었다. “다행스럽게 많은 수의 대형 소비자 사이트들은 SSL/TLS 터미네이션 (termination) 장비와 소프트웨어를 보수적으로 채택했기 때문에 구제가 되었다. 아이러니컬하게 규모가 작거나 진보적인 서비스들 또는 최신, 최선의 암호화 방식으로 업그레이드한 사이트들이 가장 큰 영향을 받았다.” - Heartbleed연구자들 어떤 사이트들이 가장 취약할 듯싶은지 알아내는 것은 꽤 간단한데, (아파치나 NGINX와 같은) 오픈소스 소프트웨어 서버의 최신 버전들을 사용하는 사이트들이 더 위험하다. F5 ADC가 Heartbleed 대응책이다. 희소식에 대해 말하자면, F5 BIG-IP 디바이스나 소프트웨어가 Heartbleed에 대한 대비책으로 사용될 수 있는 방법이 3가지 있다. 첫째: 정상적인 SSL 프로파일들이 이미 Heartbleed를 방어하고 있다. BIG-IP 플랫폼의 SSL 프로파일들이 태생적으로 보유한 SSL 터미네이션 능력을 통한 방어이다. 애플리케이션의 SSL을 종료하기 위해 F5의 BIG-IP Local Traffic Manager (LTM)를 사용하는 대다수의 사이트들은 이미 Heartbleed로부터 안전하게 보호받고 있다. 그 이유는 F5 트래픽 관리 마이크로커넬 내의 주 SSL 엔진은 F5 고유의 매우 최적화된, 손으로 직접 작성한 코드이기 때문이다. 따라서 프로토콜 서버를 대신해 F5 플랫폼이 SSL을 종료할 때는 애플리케이션에 필요한 방어를 이미 제공하는데, Heartbleed 연구가들이 취약성을 면한 “운이 좋은 소비자 사이트들”이라고 표현한 애플리케이션들이 바로 이것들이다. 즉, 비즈니스가 가동 시간 (uptime)에 많이 의존하고 용량과 서비스 제공을 위해 SSL 터미네이션 장비 (다시 말해, SSL-종료 로드밸런서)에 투자한 사이트들이다. 그림 3: BIG-IP LTM이 Heartbleed를 방어하는 방법 둘째: 하드웨어 보안 모듈들이 암호 경계를 제공 가장 안전한 SSL 키들은 금융권, 방위산업, 인증기관들이 사용하는 값이 큰 키들일 것이다. 이런 조직들은 종종 하드웨어 보안 모듈 (HSM)이라 불리는 FIPS-140 레벨3 암호 경계 내에 자신의 키를 보관하는데, 이것들은 메모리 해킹 툴들로부터 키들을 안전하게 지켜준다. 이런 기관들 중 많은 수가 통합 HSM과 함께 ADC를 사용한다. 그림 4: 네트워크 HSM 아키텍처 재미있게도 중앙 관리하에 있는 FIPS 140 암호 저장소 내에 SSL 키들이 보관되어 있는 완전히 새로운 형태의 네트워크HSM도 있다. ADC는 이런 디바이스들에게 SSL 세션 키 암호화를 해제하도록 요청하지만, SSL 세션 암호화의 나머지 부분들은 자신이 직접 처리한다. 셋째: F5 iRules가 나머지 방어를 책임진다. F5의 ADC는 다른 어떤 ADC도 갖지 못한 기능을 가지고 있는데, 완전히 프로그램이 가능하고, 데이터 플레인 스크립트 언어이다. iRules라고 불리는 이 프로그래밍 언어는 10만 명 이상의 활동적인 사용자들로 구성된 F5 DevCentral 개발자 커뮤니티가 지원하고 있다. 위에 기술된 조금 더 고전적인 SSL 종료 솔루션 두 가지 중 어떤 것도 사용할 수 없는 기관들은 SSL 커넥션을 스스로 암호해제 하지 않고 iRules를 이용해 대응하는 것이 또 다른 옵션이다. iRules에 기반한 방어 시나리오에는 다음이 포함된다: 프라이비트 키가 원래의 서버 호스트로 가지 못하도록 제한하는 보안정책을 가진 서버군 (SNI와 다른 키들을 사용하는) 멀티-테넌트 SSL 사이트를 위한 진입 지점 가상화된 SSL 사이트 군의 앞 단에 위치한 가상 ADC 이런 케이스들을 위해 F5는 Heartbleed 취약성을 완화시키는 두 종의 iRules를 작성했다. 문제 영역은 긍정오류 방지, 성능 보장, 보안이 환상적으로 혼합된 것인데, 이들은 평문(plain text)을 검사할 수 없는 단일 규칙 안에서 적절한 균형을 유지해야만 한다. 첫 번째 iRule은 클라이언트가 heartbeat 요청을 보내려는 시도를 모두 차단한다. 적법한 클라이언트는 heartbeat을 거의 보내지 않기 때문에 iRule이 악의적인 클라이언트를 모두 차단하며 BIG-IP 후단에 있는 서버에 공격이 도달하는 것을 방지한다. 두 번째의 iRule은 서버 메모리의 한 부분을 포함하고 있을지도 모르는 대규모 heartbeat 응답을 서버가 전송하는 것을 막는다. 만약 이 두 iRules 중 어떤 것도 충분하지 않다면, 각 기관은 자신 스스로 개발할 수도 있으며, 이런 일은 거의 매일 발생한다. 이것이 바로 iRules와 DevCentral의 힘이다. (제 2부에 계속)144Views0likes0CommentsIT security isn’t one size fits all

The security landscape today is highly complex, which can largely be attributed to the increasingly sophisticated nature of cyber attacks, particularly from an execution perspective. For example, DDoS attacks are now reaching speeds of up to 400Gbps, targeting both the network and application layer. Evidently, attackers are progressing towards other methods to bypass traditionalsecurity defenses, including the firewall. In this particular scenario, the challenge for organisations with application-layer DDoS attacks is to differentiate human traffic from bot traffic. In addition, the motivation behind attacks is becoming more complex especially from a political and economic standpoint. The NSA leaks by Edward Snowden, which revealed classified information from governments including the US, UK, Australia, Canada, and New Zealand is a recent example of a high profile hacking incident that certainly reminds us of this fact. Moreover, one of the biggest threats to IT security is now organsied cyber theft and fraud, as the smartest criminals in the world are increasingly realising the substantial financial gains that can be made via online crime. Hence, the need for an enterprise to ensure it is adequately protected against cyber attacks is becoming increasingly critical. An effective security strategy will cover all devices, applications and networks accessed by employees, beyond the enterprise infrastructure itself. Traditional security methods such as next generation firewalls and reactive security measures are losing the fight of being effective against the new breed of attacks. Security is now very much about the protection of the application, enforcement of encryption and the protection of the users identity, and less about the supporting network infrastructure. This is because it has become far less static in recent times and has truly proven to be nothing more of a commodity transport vehicle for the complex applications that run on top of it. What organisations need is a security strategy that is flexible and comprehensive, with the ability to combine DNS security and DDoS protection, network firewall, access management, and application security with intelligent traffic management. Developments in the market which has seen theintegration of WebApplication Firewalls (WAFs) with Application Delivery Controller (ADC) platforms, as recognised by a recent study by Frost & Sullivan (the Frost Industry Quotient), has driven F5 to create a new vision / architecture called F5 Synthesis for the application delivery market. This vision offers a high performance network fabric to protect fundamental elements of an application (network, DNS, SSL, HTTP) against sophisticated DDoS attacks. F5 Synthesis, through the use of tested reference architectures, ensures that applications are kept secure and available as customers make the journey toward software defined data centres (SDDS). Moreover, F5’s DDoS protection solution delivers the most comprehensive attack protection available on the market to date. While the average DDoS attacks reach 2.64 Gbps, upgrades to F5’s BIG-IP platform allow servers to handle attacks as large as 470 Gbps. Not only is there enough bandwidth to mitigate a DDoS attack, the extra capacity allows online companies to continue normal business - even while under attack. Security won’t be one size fits all during 2014. End users will expect high performance, however organisations must ensure they deploy security solutions that don’t become a bottleneck. This year, we can expect to see a rise in a multi-dimensional or 'cocktail' style attacks: DDoS attacks combined with application layer attacks and SQL vulnerabilities. As such, the traditional firewall is no longer a viable security defense, and organisations need to have a multi-stack security approach, combined with a process to handle internal control. With attacks from multiple angles on different devices, single-purpose security machines will be phased out in favour of sophisticated multi-purpose machines.238Views0likes0CommentsWho needs a Bot Army these days?

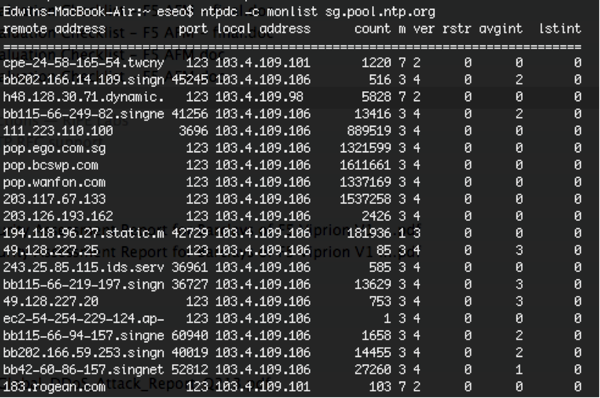

It’s been a while - a long while - since I last (officially) blogged. Too many distractions with a new role, new travels, and a new family member - sucks away the creative juices. Alas, sitting at an airport lounge after a 3 city Security Roadshow in Bombay/Delhi/Bangalore brings out the adrenaline rush of blogging once more. I’ve been evangelizing the need for DoS protection for quite a while. Events of last year (2013), and even the beginning of 2014, have made my job easier (Happy New Year!). I used to equate DoS (rather Distributed DoS) attacks with Bot Armies - kinda like the Orcs that we saw in the LOTR (Lord of the Rings**) saga. The Bots (Orcs) still exist - but seems like the Bot Herder (I’ll call him “Sauron” **) is summoning a new type of Army these days - a new generation of orcs used to carry out his mission to wipe a particular service/server from the face of the Internet world - You and Me! Yes - US! Who needs a Bot Army these days? There are gazillions of Internet users and servers out there. There isn’t a need for any kind of endpoint infection/malware. That would be troublesome. All you need is an unsuspecting (and poorly protected) + popular web server, and some programming flair with JavaScript (JS) or iFrames. Then you need to compromise that popular web server and input the malicious JS/iFrame into the landing web page. So when a user visits this compromised popular website (e.g. an online gossip portal) to read about the latest Hollywood gossips, the hidden JavaScripts or iFrames gets executed within his browser and causes him to send multiple GET requests to the victim. And the victim gets hoarded with a torrent of GET requests, and if its not sufficiently and appropriately protected, guess what happens? Bam! 2014 began with an interesting new type of attack against a couple of gaming sites like League of Legends, Steam and Battle.net using yet another type of “botnet”, except that these weren’t bots but actual Network Time Protocol (NTP) servers. The NTP protocol is used by many servers and endpoints to sync system clocks - for example my mac uses time.asia.apple.com. Leveraging the inherent “trust” that the UDP protocol exhibits (aka stateless), and a relatively forgotten command called “monlist”, this is how it works. From my laptop, a small query of 234bytes returns a response of 100 packets each of 482bytes, producing an amplification factor of approximately 205x (you get the hint). So I need to be armed with a list of open and unpatched NTP servers (which isn’t difficult to find - there are automated programs out there that can “assist"), and spoof the IP address of someone whom I don’t like, and shazam. An example of the now infamous “monlist” command for an unpatched NTP server looks like: This reminds me of the DNS Reflective Amplification attacks during the Cyberbunker-Spamhaus saga in March of last year (2013). Again, the trust model of the DNS protocol was exploited, and what that didn’t help with the problem were those 20-something million open DNS resolvers which neither perform any kind of filtering nor any request verification or traffic management of DNS responses. And as a result, 300Gbps of DNS responses towards an unsuspecting victim, which even caused collateral damage to International Peering exchanges. Now, how do we deal with these? For the DNS and NTP reflective amplification attacks, apart from deciding to not be an open DNS resolver, or disabling the “monlist” command, if you are a service or hosting provider to one of these potential “Orcs”, one simple way is to monitor the outbound BPS/PPS/Number of connections originating from the server. When it gets anomalously high, move to the next step of monitoring perhaps the Top 10 destinations these guys are sending towards. It doesn’t make sense that a DNS server out there is sending 1M DNS “Any” responses per second to www.f5.com. Apply an appropriate rate shaping policy as needed and that will help protect your own network infrastructure, save some peering/transit costs, and help the poor victim. The HTTP reflection attack is a bit more challenging, given that as mentioned previously - it isREALHTTP traffic fromREALbrowsers out there. You can’t filter based on malformed HTTP packets. You can’t filter based on URL since it’s typically a legitimate URL. This calls for Anti-Bot Intelligence, like: TCP SYN Cookie verification (L4) HTTP Redirection verification (L7) JavaScript / HTTP Cookie verification (L7) CAPTCHA verification (L7) With the ability to step-up countermeasures dynamically and when needed. Of course, the latter verification methods are higher in the OSI stack (Layer 7), more advanced and computationally more expensive to perform. Here at F5, we’ve found that (3) and (4) have been extremely effective in terms of combating DoS tools/scripts and even the hidden JavaScripts/iFrames mentioned above. These guys typically bail out when it comes to solving complex JavaScript puzzles or checking of mouse/keyboard movements etc., and not to mention solving CAPTCHA puzzles. Once this happens, throw the errant source into a penalty box for a period of time, then repeat the rinse and lather. Dynamically increase this penalty box timeout when the errant source fails multiple times. This will effectively thwart any attempt from the errant source in sending HTTP requests to the victim server. Lastly, work with your upstream service provider, or engage a cloud-based anti-ddos service when the attacks become too large to handle. Sound the SOS! It is common-sense the only possible way to mitigate 300Gbps floods is in the service provider cloud / cloud-based anti-ddos service, likely using a distributed scrubbing “anycast” model, where each distributed scrubbing center sucks in the traffic destined for the victim like a big washing machine and starts cleaning. That said, there are many ways to skin a cat - likewise, there are many ways to solve a DoS problem. Pay particular attention to attacks as they move up the OSI stack toward Layer 7. These are typically harder to mitigate, but fortunately not for F5. So if you’re thinking that botnet armies are the Sole source of menace in the DoS world out there, they’re not. Everyday Internet users like you and me could be an unsuspecting participant in the world’s largest DoS to be. ** Source: The Lord of the Rings, J.R.R Tolkien, 1954262Views0likes0Comments사물인터넷이 ‘사회적 지능’에 대한 요구를 증가시킨다

‘혁신은 리더와 추종자를 구분하는 잣대이다.’ 스티브 잡스가 남긴 말로 글로벌 플레이어가 되기 위해 노력하는 기업들에게 있어 정곡을 찌르는 말이다. 오늘날 사물 인터넷 (Internet of Things/ IoT)은 수많은 분야에 기술혁신을 불러왔고, 이러한 현상은 이미 빌딩, 기차, 병원 및 공장에서의 센서 네트워크 혹은 지능형 도로와 같은 다양한 기업 및 공공분야로 퍼져나가고 있다. 사물인터넷(IoT)이라는 용어는 간략하게 설명될 수 있다: 이것은 실시간의 정확한 데이터 감지, 측정 역량과 함께 이 데이터를 네트워크 상의 다른 사물에게 무선으로 전송할 수 있는 역량을 가능하게 만드는 기술이다. 예를 들어, 센서가 장착된 제품들은 기업이 해당 제품의 움직임을 추적하고, 어떠한 상호 작용이든 모니터링 할 수 있도록 해준다. 기업의 결정권자들은 이러한 데이터를 직접 보유함으로써 기존의 비즈니스 모델을 보다 섬세하게 조율할 수 있는 이점을 누리게 된다. 한편, 포레스터 리서치 (Forrester Research)의 2014년 아시아태평양 기술 시장을 위한 Top 10 전망에 따르면, IoT는 비즈니스를 넘어서 개인의 일상에까지 변화를 가져오고 있다. 센서들은 사람들이 더욱 균형 잡힌 체형을 유지하고, 키를 찾는다거나, 집의 문을 열고, 주위의 기온을 모니터링 하는 등 여러 가지를 가능하게 만들고 있는 것이다. 사물 인터넷과 함께 부상하고 있는 것들 중 하나는 연결의 증가인데, 이는 불가피하게 트래픽 폭증을 유발하고, 그에 따라 기존 네트워크 인프라에 부담이 가중되어 그 어느 때보다 확장성과 유연성이 뛰어난 지능적인 인프라가 요구된다. 포레스터의 애널리스트 미쉘 펠리노 (Michele Pelino)는 새로운 기술들이 광범위하게 적용되기 전에 먼저 해결해야 할 중요한 이슈 하나는 IoT 생태계가 발전되어야 한다는 것이라고 최근 말했다. 하지만, 기업들이 당면한 첫 번째 과제는 현재 운영중인 IT 인프라가 자사 비즈니스 상의 요구를 수용할 수 있을 만큼 신속하게 확장되지 못한다는 점이고, 두 번째는 펠리노(Pelino)가 지적했듯이, 다양한 소스로부터의 모든 데이터를 이용해 분석적인 통찰력을 제공할 수 있는 독립적인 소프트웨어 제공업체들의 검증된 생태계가 필요하다는 것이다. 마지막으로는 통상적으로 새로운 기술의 적용에는 관련 정책과 비즈니스의 변화로 인해 상당한 시간이 소요된다는 점이다. 기술적인 관점에서 보면, 이는 분석 엔진, 비즈니스 지능 소프트웨어 그리고 더 중요한 지능적인 애플리케이션 딜리버리 인프라와 같은 정보처리 툴들이 장착된 데이터센터에 의존하게 된다는 의미이다. 분석은 필요한 ‘사회적 지능’을 제공해 기업이 이용하도록 만드는 반면, 지능적인 애플리케이션 딜리버리 시스템은 그러한 통찰력이 실시간으로 안전하게 최종사용자들에게 전달되는 것을 보장한다. 실시간의 안전한 ‘사회적 지능’에 대한 이런 필요는 IoT가 주도하는 지능에서 생겨나고 일련의 애플리케이션 서비스들을 만들어낸다. 결국 이러한 통찰력은 적절한 결정권자들에게 배달되어야만 하는데, 비즈니스 지능 애플리케이션들을 통해 흐르는 데이터에 대한 실시간 트래픽 최적화, 가용성 및 보안을 제공하는 서비스들이 이것을 가능하게 만든다. 궁극적으로 이러한 솔루션들은 인프라를 단일 지점에서 관리해야만 하며, 이로 인해 오랜 시간에 걸친 애플리케이션 딜리버리 진화의 다음단계인 SDAS의 탄생을 불러오게 되었다. SDAS는 하나의 통합된 고성능 애플리케이션 서비스 패브릭으로 매우 유연하면서 프로그래밍이 가능한 애플리케이션 서비스를 제공하려는 노력의 결과이다. 지능적으로 통합된 SDAS는 오늘날 IT에 불어 닥친 엄청난 소용돌이와 관련된 중요한 난제들을 해결해줄 수 있다. 궁극적으로SDAS는 물리적, 가상 및 클라우드로 구축된 플랫폼들의 조합에서 자원들을 이끌어내어 활용할 수 있는 추출 능력에 의존한다. 전반적으로, IoT는 개개인의 삶과 기업의 비즈니스 환경에 매우 매력적인 혜택을 약속하는 기술이다. 필연적으로, 후단의 백엔드 기술도 이러한 발전과 발맞추어야 하고, IoT 시대를 맞아 그 어느 때보다도 복잡해질 것이다. Original blog post by Kuna.149Views0likes0CommentsF5 예측 - 사회적 기술의 확산이 보안위협을 증가시킨다.

‘F5 예측’ 시리즈를 시작하며 그 첫 주제로 기업들이 무시하기 어려운 것으로 판명된 이슈를 택했는데, 그것은 바로 기업에 사회적 기술 (SNS 기술)들이 홍수처럼 몰려오고 있다는 것이다. 많은 기업들은 생산성 향상, 더 효율적인 근무 환경, 동료와 부서들간의 더 긴밀한 협업, 그리고 고객과 기업 사이의 더욱 확대된 브랜드 경험 등 이 기술이 가져오는 가치에 대해 잘 이해하고 있다. 많은 기업들이 시장의 진화도 목격하고 있다. 특히, Y세대와 Z세대는 조금 더 사회화된 근무환경을 요구한다. 싱가포르를 예로 들자면, 이 두 세대는 전체 근로자의 60%를 차지한다. 이 새로운 세대는 베이비붐 세대 이후 가장 수가 많은 연령대로 부상했는데, 그들은 고등 교육을 받았고, 여행도 많이 하며, 기술에 익숙하고, 멀티태스킹이 가능하며, 사회적인 교류를 추구하는 사람들이다. 밀레니엄세대는 가장 전통적인 기업들조차 더욱 협업적이고 사회화된 환경을 구축하도록 촉구하고 있다. 이러한 새로운 유형의 직원들에 맞추어서, 관리자들은 이 사용자들의 행동을 충분히 이해하는 한편 직장에서의 안전한 사회적 환경을 보장하는 새로운 가이드라인을 도입해야만 한다. 고객들에게는 안전한 환경에서 비즈니스와 브랜드 충성도를 만들어내기 위해 사용자 행동을 이해해야 한다. 실제로 컨설팅 회사 언스트 영 (Ernst & Young)의 2013년 글로벌 정보보안 설문조사 (Global Information Security Survey 2013)에 따르면, 보안은 기업들에게 아킬레스 건과 같은 것이다. 응답자의 31%가 지난 12개월 동안 보안사고가 최소 5% 이상 증가했다고 답했다. 게다가, 83%의 조직에서 보안부서가 니즈를 충분히 충족시키지 못한 것으로 이 조사 결과에서 나타났다. 기업들은 평판, 수입 및 책임 등 그 이유야 무엇이 되었든 사이버공격으로부터 그들을 보호하는 일에 열의를 기울이고 있다. 보안 위험을 고려하지 않는 기업들은 사이버공격의 쉬운 목표가 되어, 조직의 평판을 위태롭게 할 수 있기 때문에 이렇게 보안에 열의를 보이는 것은 올바른 방향이다. 조직이 새로운 기술을 도입할 때 보안은 가장 큰 장애물들 중 하나다. 과거에는 기업들이 데이터를 벽 뒤에 보관하고 통제할 수 있었지만 점점 새로운 기술들이 나타나면서, 고객 데이터는 더욱 노출되었다. 보안 침입 건수 역시 증가하고 있다. 그럼에도 불구하고, 기술진화의 속도는 오로지 가속화될 뿐인데, 이 젊은 집단들의 ‘사회적’ 요구에 의한 것이 그렇다. 베이비붐 세대가 한때 그랬듯이 밀레니엄 세대가 곧 노동인구의 대부분을 차지하게 될 것이다. 기술을 잘 다루고 고도로 모바일적인 이 세대는 인터넷과 함께 성장했으며, 이미 데스크탑 컴퓨터에서 그랬듯이 모바일 디비이스에서도 업무와 재미를 위한 정보를 손쉽게 누릴 수 있기를 기대한다. 그리고 이 젊은 세대들은 가장 큰 고객군이 될 것이며, 가상 공간에서 살아갈 것이다. 종합해보자면, 기술과 이 새로운 그룹의 요구는 각각의 분야가 겪어야 할 변화를 주도할 것이다. 은행 분야를 보자면, 밀레니엄 세대는 언제 어떤 방법으로든 서비스를 이용하고 거래를 할 수 있기를 기대한다. 모빌리티 전략은 어떤 기업이든지 쉬운 일이 아니다. 고려해야 할 부문에는 애플리케이션과 데이터에 대한 접근, 보안정책과 사용자 편의성 사이의 균형, 필요한 정보를 제공하고 거래를 완료시키는 속도, 그리고 브라우징의 용이성 등이 포함된다. 대부분의 기업들에게 있어 모바일 애플리케이션을 구현하고 이를 유지하는 것은 시간과 자원이 많이 투입되는 임무이다. 기업들에게 필요한 것은 웹 취약성을 낮게 유지하는 동시에 이미지가 많이 포함된 컨텐츠 전송을 돕고, 모바일 네트워크의 지연을 단축하기 위해 트래픽에 우선순위를 매기고, 애플리케이션 성능에 가시성을 제공하는 등의 임무를 모두 수행할 수 있는 후방 인프라다. 또한, 사이버 범죄가 갈수록 복잡해지고 다양한 디바이스에 대해 여러 방향으로부터의 공격이 이루어짐에 따라 정교한 다목적 기계보다는 단일 목적을 위한 보안 솔루션이 선호될 것이다. 기업들이 어느 디바이스에서나 빠르고 신뢰할 수 있는 사용자 경험을 기대함에 따라 성능의 맥락에서도 이러한 융합은 계속 발생하게 될 것이다. Original blog post by Kuna.170Views0likes0Comments